Nous en parlions les semaines précédentes avec nos précédents articles sur Stable Diffusion et Midjourney, deux IA permettant de créer des images à partir de texte… la possibilité de pouvoir, d’ici quelques temps, générer des modèles 3D de la même façon, via une IA. Hé bien, c’est chose faite avec Get3D de Nvidia, petit point sur cette technologie.

Sommaire

Générer des modèles 3D automatiquement ?

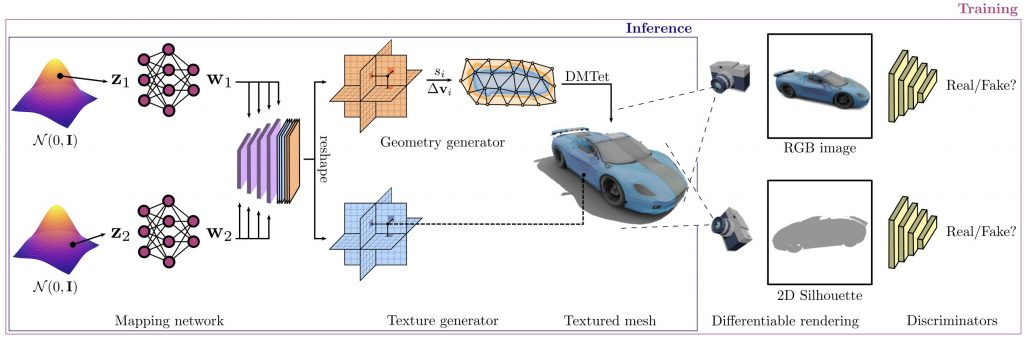

Nvidia vient d’annoncer un nouveau modèle d’IA capable de générer des objets en 3D à partir de quelques images 2D prises sous plusieurs angles. Les modèles obtenus sont texturés HD avec un maillage de haute précision.

Selon ce billet de blog de NVIDIA, les ingénieurs ont entraîné le modèle d’IA avec un million d’images. Avec l’aide de plusieurs GPU A100 Tensor Core, l’équipe a atteint son objectif en deux jours. Selon l’entreprise, GET3D est capable de produire 20 objets par seconde en utilisant un seul GPU. Jusqu’à présent, GET3D est capable de générer une variété d’objets allant des voitures, chaises, animaux, motos, humains et bâtiments. Le modèle peut être associé à un autre outil d’IA NVIDIA pour créer l’objet dans un style spécifique. Les ingénieurs affirment qu’il peut créer des maillages 3D bien détaillés, avec une topologie complexe et des textures réalistes, qui peuvent être exportés vers des moteurs de jeux ou des applications de rendu.

À première vue, le résultat est similaire à celui que nous obtenons si nous utilisons la technique de la photogrammétrie, avec un modèle de maillage et de texture détaillé. Le seul inconvénient est que ce type de modèles nécessite un certain travail de « nettoyage » par la suite pour optimiser le nombre de polygones. Ici, c’est l’IA qui assure l’ensemble des opérations.

Voici une présentation rapide (trop probablement) de Get3D :

Techniquement, ça fonctionne comment ?

Si vous souhaitez en savoir plus sur cette technologie, je vous propose de consulter ce papier, GET3D : un modèle génératif de formes texturées 3D de haute qualité apprises à partir d’images de Jun Gao , Tianchang Shen , Zian Wang , Wenzheng Chen , Kangxue Yin , Daiqing Li , Or Litany , Zan Gojcic et Sanja Fidler.

Dans ce document de 39 pages, vous aurez une présentation détaillée de la méthode utilisée, des différentes expériences réalisées avant d’en arriver à un modèle fonctionnel, etc. Il est notamment question du Text-Guided 3D Synthesis, comme nous l’avions évoqué, c’est à dire la possibilité finalement d’utiliser un équivalent de Stable Diffusion, Midjourney ou Dall-E pour générer des images, et puis de les transformer en 3D.

Pour les dernières nouvelles de la recherche sur l’IA de NVIDIA , regardez la rediffusion du discours d’ouverture du fondateur et PDG de NVIDIA, Jensen Huang, au GTC :

Le futur de Metaverse ?

Finalement, on se demandait comment peupler un métaverse rapidement, ce n’est peut-être pas pour rien que les recherches se focalisent sur ce genre d’outils en ce moment. Tout cela me fait penser qu’on est peut-être proche d’inventer la machine à rêver… quelques mots pour générer des images, des modèles 3D… un univers qu’on peut visiter en temps-réel, fantasmagorique… un futur outil pour vivre des aventures (il ne manquera plus que la génération de scénario via IA) ou soigner des patients… En attendant, il faut s’attendre à ce que la production de jeu vidéo soit de plus en plus accessible. Avant, on pouvait acheter des assets… désormais, on pourra les générer automatiquement ! Bon, c’est pas encore au point totalement, mais c’est quand même bien parti.

Pour plus d’informations, on pourra consulter la page du projet. On y trouvera la publication complète, davantage de visuels, mais aussi du code qui sera mis en ligne dans la semaine.

0 commentaires