Ninja Theory (NT) est une société spécialisée dans le développement de jeux vidéos. Ce sont les développeurs du jeu « HellBlade« .

Ces derniers nous proposent une série de vidéo représentant un making of de leur dernière production. Même s’il s’agit d’une petite équipe composée de 16 personnes, ce qu’ils ont réalisé est assez extraordinaire – plus précisément c’est ce workflow combinant plusieurs technologies et compétences autour de NG, Epic Games, 3Lateral (character design), Cubic motion (facial tracking), Ikinema (motion capture) et Xsens (combinaison de mocap).

3Lateral, c’était eux qui avait participé à la conception du gamin dans la démo de l’enfant et du cerf-volant présentée à la GDC 2015 dans le cadre des Open Worlds. Leur compétence: du concept du personnage au rigging, en passant par le scan facial. Ils ont travaillé de concert avec Cubic Motion pour le facial Tracking. Epic avait déjà collaboré avec plusieurs sociétés sur 3Lateral, pour le projet Paragon, c’est encore le cas. Naturellement, toutes les technologies de base des modèles de Epic Paragon devaient être transférés et ajoutés à la plate-forme 3Lateral.

La technologie de Motion cubique, société de Manchester, peut suivre plus de 200 traits du visage à 90 images par seconde et mappe automatiquement ces données en haute qualité et en temps réel. (Au GDC, le système fonctionnait à 30fps pour les démos).

La vidéo suivante nous montre un système permettant de reproduire en « direct » les mimiques du visage d’une personne sur un personnage animé, comme on peut le voir sur la vidéo suivante:

Cette facilité va devenir la norme dans les jeux vidéos, les animations, …

Toutes ces expressions « faciales », une centaine, sont ainsi stockées et peuvent être réutilisées, combinées à loisir. Cela a pris une journée complète pour tout scanner. Ce n’est pas comme juste filmer une scène.

L’équipe de Epic travaillait déjà sur un matériel de démonstration pour le jeu Paragon et avait ainsi mis en place de nouveaux outils dont nous avons parlé pour la dernière version de Unreal Engine, mais il n’y avait toujours pas d’outils en temps-réel.

Parmi tous les éléments travaillés, il y a la séparation de l’ombrage spéculaire de l’ombrage diffus pour un contrôle plus isolé, une micro carte détaillée sur la peau avec rides pour produire une peau correcte avec des détails fins. La gestion des normales a été bien améliorée aussi.

La performance était non seulement en live, mais aussi enregistrée et mixée (image dans l’image). Comme il y avait 1 275 milli-secondes de décalage entre l’interprète et la visualisation sur le projecteur, il a donc fallu mettre en place des retards audio pour maintenir la synchronisation des lèvres ! Ben oui, ce serait con sinon !

NT a également conçu une extension pour UE4 pour l’éclairage Volumetrique.

Le modèle Melina a été scanné sous toutes les coutures, jusqu’aux détails de sa peau et elle est parfaite ! 🙂

Bon, dans la vidéo, ils précisent bien que la salle de scan restera confidentielle, mais mélina nous dit avoir l’impression d’être rentrée dans un vaisseau spatial.

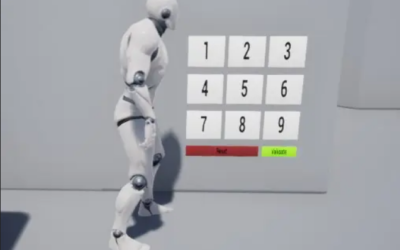

Un coup d’oeil derrière la mocap régulière mis en place pour Hellbalde .

La taille du studio n’est pas très grande: besoin de 2 techniciens, du metteur en scène et de l’actrice.

Pour la mocap, ils utilisent le Vicon Bonita motion capture system qui est l’un des moins cher sur le marché. Pourquoi parlent-ils d’Xsens, c’est une bonne question…

Ce qui est bluffant, c’est la partie enregistrements sonores: pour ne pas exploser le budget, ils utilisent des rideaux épais pour éviter la réverbération des sons ! Pour éviter de produire des bruits en marchant: de gros tapis bien épais !

Le casque a été réalisé par Technoprops: on peut l’équiper de 1 à 4 caméras, 2 étant un bon compromis entre qualité et poids pour l’actrice.

Pour en savoir plus: https://www.fxguide.com/featured/epic-face-work-with-ninja-theory/

0 commentaires